https://anlatilaninotesi.com.tr/20220216/oluleri-canlandirmaktan-santaj-videolarina-deepfake-nedir-ve-hangi-tehlikeleri-iceriyor-1053901032.html

Ölüleri ‘canlandırmaktan’, şantaj videolarına: Deepfake nedir ve hangi tehlikeleri içeriyor?

Ölüleri ‘canlandırmaktan’, şantaj videolarına: Deepfake nedir ve hangi tehlikeleri içeriyor?

Sputnik Türkiye

Görüntü ve sesin değiştirilebildiği bir medya türü olan deepfake ile ölmüş kişilerin eski fotoğrafları hareketli hale getirilebiliyor ve ABD’li bir annenin... 16.02.2022, Sputnik Türkiye

2022-02-16T13:24+0300

2022-02-16T13:24+0300

2022-02-16T17:03+0300

görüş

deepfake

görüntü

ses

deniz unay

deep nostalgia

myheritage

canlandırma

manipülasyon

dolandırıcılık

https://cdn.img.anlatilaninotesi.com.tr/img/07e6/02/10/1053901007_0:250:2753:1799_1920x0_80_0_0_8f8fce57fa0887666fd463f74acbb0de.jpg

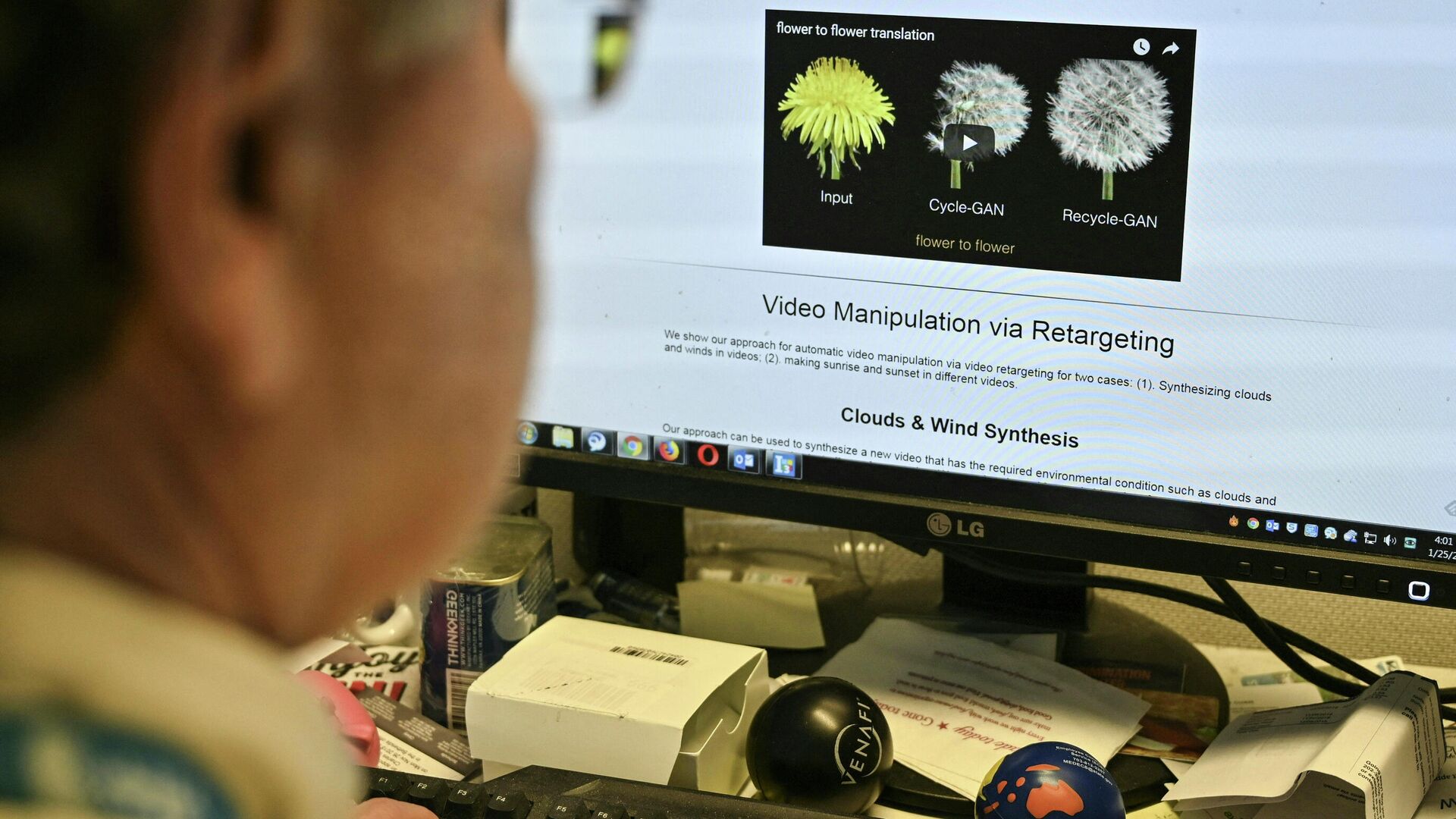

Teknolojinin geldiği noktada akıllı telefon uygulamalarıyla yüze çeşitli filtreler eklemek ve hatta daha genç ya da yaşlı görünmek mümkün. Son günlerde Fransız bir film yapımcısının, Türk doktor sandığı 20 yaşındaki hacker Nijeryalı’ya ‘aşık’ olmasıyla gündeme tekrar gelen deepfake teknolojisi ise, bir görüntü ve işitme manipülasyonu yöntemi olarak tanımlanıyor. Mevcut bir görüntü veya videoda yer alan bir kişinin, yapay sinir ağları ile birlikte bir başka kişinin görüntüsü ile değiştirildiği bir medya türü olan deepfake, makine öğrenme tekniklerini kullanarak, mevcut medyanın kaynak medya üzerinde üst üste konulmasıyla elde ediliyor.Deepfake görüntüleri hangi amaçlarla kullanıldı?Mevcut durumda, bu teknoloji ile ölmüş kişilerin fotoğrafları 'canlandırılabiliyor'. Ölmüş yakınlarla özlem giderilmesini amaçlayan İsrail merkezli soyağacı oluşturan bir çevrimiçi platform olan Myheritage’ın piyasaya sürdüğü Deep Nostalgia, video canlandırma yoluyla eski fotoğrafları hareketli hale getiriyor, hatta fotoğraflardaki kişileri gülümsetiyor. Herhangi birinin fotoğrafını çıplak hale getiren Deepnude uygulaması da sadece kadın fotoğraflarında ‘çalışması’ üzerine gelen eleştiriler dolayısıyla 2019 yılında kapatıldı.Bu teknolojiyi kullanarak üretilen içerikler için bir diğer örnek ise eski ABD Başkanı Barack Obama’nın, zamanın başkanı Donald Trump’a küfür içerikli ifade kullandığı video. Bu videoda oyuncu ve yönetmen Jordan Peele’ın dudakları Obama’nın görüntüsünün üzerine eklenmiş durumda ve Obama’nın ağzından çıkan her kelime Peele’a ait. ABD’li bir kadın olan Raffaela Spone da, kızının amigo takımına girebilmesi için, diğer gençlerin içki, sigara içtiğini gösteren ve hatta onları çıplak biçimde tasvir eden video ve fotoğraflar için bu teknolojiyi kullandı.‘Derin öğrenme’ ve ‘sahte’ kelimelerinin İngilizcesinden türetilmiş bir isme sahip olan bu teknolojiye Türkiye’de 2020 yılında Kemal Sunal’ın ‘başrolünde’ oynadığı bir reklam filmiyle ilk olarak rastlandı. Ancak, bu teknolojinin kullanıldığı alanlar maalesef, sadece eğlenceli videolar değil. Türkiye’de bir kadın üniversite öğrencisinin görüntüleri deepfake uygulaması kullanılarak müstehcen görüntülere eklendi ve kadın öğrenci şantaja uğradı.Bu videolar nasıl oluşturulur?Deepfake içerikleri pek çok internet sitesi ve uygulama üzerinden yapılabiliyor. Ancak, TikTok'ta viral olan, aktör Tom Cruise'un deepfake videolarının yaratıcısı Chris Ume’a göre, bu videoları yapmak çok da kolay değil. Ume, yarattığı videolar için aktörün farklı açılardan ve yüz ifadeleri ile 6 binden fazla görüntüsünü topladığını ve sadece deepfake teknolojisini kullanmadığını söyledi. Dijital grafik yazılımlarıyla görüntüyü kare kare düzeltmek için uğraşan Ume’un videoları oluşturması 2 ayından fazlasını aldı.Derin öğrenme alanında araştırmalar yapan ve şu anda Apple’da makine öğrenimi yöneticisi olan Ian Goodfellow tarafından 2014 yılında icat edilen ‘çekişmeli üretici ağ’ (GAN) teknolojisiyle var olan deepfake’in tehlikeleri ne ve hangi önlemler alınmalı? Teknoloji uzmanı Deniz Unay, Sputnik’e anlattı.‘Yararları olduğu kadar bu teknolojinin tehlikeli bir silaha dönüşebileceği uygulamalarda yer alıyor’Temelde makine öğrenimi sınıfı olan GAN’ın, beraberinde tıp alanında kullanılan MR’dan tasarımcıların yeni kıyafetlerini modeller üzerinde sanal ortamda denemelerine kadar birçok yeni uygulamanın da ortaya çıkmasını sağladığını söyleyen Unay, “Yararları olduğu kadar bu teknolojinin tehlikeli bir silaha dönüşebileceği uygulamalarda yer alıyor. Bunlar arasında Deepfake ile oluşturulmuş insan modelleri ile videolar, belgeseller, filmler ve hatta röportajlar bile hazırlanabilir hale gelmiştir. Özellikle son dönemde gelişen uygulamalar normal bir insan tarafından anlaşılması neredeyse imkansız hale gelen görüntülerin ve seslerin ortaya çıkmasını sağlamıştır” dedi ve “Söz konusu teknolojinin yeniden gündeme gelmesinde ise Metaverse kavramına bağlanması mümkündür. İnsanların kendi üç boyutlu görüntülerini tasarlayacakları bu evrende GAN ile çok daha başarılı sonuçların elde edilmesi mümkündür” diye ekledi.‘Deepfake teknolojisiyle yapılan dolandırıcılık tehlikesi artıyor’Unay, bu teknolojinin kullanıldığı dolandırıcılık olaylarına da dikkat çekerek “Deepfake üzerinden artan dolandırıcılık faaliyetleri ise günümüzde birçok kişi için tehlike oluşturmaya da devam ediyor. Deepfake yardımıyla oluşturulan sahte görüntüler, özellikle ünlüler, siyasiler veya toplum tarafından tanınan bilinen kişilerin gerçekte var olmayan bir yerde olmasını, söylemedikleri şeyleri söylemeleri ve bunları yaparken de gerçeğinden ayırt edilmemeleri çok ciddi bir tehlikenin ortaya çıkmasına neden olmuştur. Deepfake teknolojisi kullanılarak yapılan dolandırıcılık faaliyetlerinin bazılarına bakıldığında bu uygulamaların gelecekte daha da tehlikeli boyutlara varabileceği düşüncesi iyice yerleşmiş durumda” diye konuştu ve dolandırıcılık örneklerini şu şekilde sıraladı:Ses taklidiyle para çekmeden, seks şantajına kadar uzanıyor‘Toplumsal olaylarda sahte görüntülerin kısa sürede yayılması ve etkileşim alması çok daha geniş kitlelerin manipüle edilmesine neden olmaktadır’Deepfake’in topluma olan etkisinden de bahseden Unay, seçim zamanlarında da manipüle edilmiş görüntülerin sunulabileceğinin mümkün olduğunu belirtti. Unay “Sahte bir profilin ötesine geçerek gerçek bir kişi gibi davranan bu hesaplar zaman içinde kalabalık kitleleri sokağa dökebilir ve yanlış siyasi yönlendirmeler ve bilgiler ile iç karışıkları bile tetikleyebilir. Seçim dönemlerinde ise Deepfake ile yapılan videolar ve gerçekte asla söylenmemiş şeyleri belirli siyasi kişilerin demeçleri olarak yansıtılabilir. Bu sayede Deepfake teknolojisinin seçimlere etkisi görülebilecektir. Toplumsal olaylarda sahte fotoğraf, resim, ses ve videoların kısa sürede sahte hesaplar aracılığıyla yayılması ve yüksek etkileşim alması çok daha geniş kitlelerin manipüle edilmesine neden olmaktadır. Bu gibi durumlara karşı hükümetlerin de zaman zaman aldıkları önlemler tartışma yaratmaktadır” dedi.Deepfake teknolojisiyle üretilmiş videoların gerçekliğinin çok zor bir şekilde anlaşılabildiğini söyleyen Unay’ın aktardığına göre, buna karşı herhangi bir önleyici yazılım ya da uygulama bulunmuyor.Deepfake dolandırıcılığına karşı hangi önlemler alınabilir?Bu teknoloji ile gerçekleştirilen dolandırıcılık faaliyetlerin korunmanın yollarını anlatan Unay “Özellikle bankacılık işlemlerinde ve uygulamalarında birkaç farklı adımdan oluşan güvenlik sistemlerinin kullanılması son derece önemlidir. Diğer yandan sesli tanıma özelliklerine sahip işlemlerin de kapatılması dolandırıcılıktan korunmanız için oldukça önemlidir. Sosyal medya veya internet üzerinde karşınıza ilk çıkan video, fotoğraf veya sesleri ilk anda doğru kabul etmemek özellikle toplumsal olayların önlenmesinde önemlidir. Bir olay sonrasında sıcağı sıcağına sosyal medyada yayılan birçok bilgi ve görüntünün sahte olduğu çok sık rastlanan bir durumdur. Bu duruma karşı alınacak önlem ise ilgili unsurların teyit edilmesi olacaktır. İnternette güvenliğin artırılmasına yönelik dikkat edilmesi gereken temel yaklaşımların tümü Deepfake dolandırıcılığına karşı kendinize daha güvenli bir alan yaratmanızı sağlayacaktır. Ancak bu teknolojiden tamamen korunmak günümüzde neredeyse imkansızdır. Bu nedenle alınabilecek basit önlemler ile internetteki varlığınızı güvence altına almak ve deepfake tehdidine karşı bilinçlenmek son derece önemlidir” ifadelerini kullandı.

Sputnik Türkiye

feedback.tr@sputniknews.com

+74956456601

MIA „Rossiya Segodnya“

2022

Turan Salcı

https://cdn.img.anlatilaninotesi.com.tr/img/07e6/0b/1d/1063968283_0:16:787:803_100x100_80_0_0_387a309ad057f292b54c4dbdabaf3452.jpg

Turan Salcı

https://cdn.img.anlatilaninotesi.com.tr/img/07e6/0b/1d/1063968283_0:16:787:803_100x100_80_0_0_387a309ad057f292b54c4dbdabaf3452.jpg

SON HABERLER

tr_TR

Sputnik Türkiye

feedback.tr@sputniknews.com

+74956456601

MIA „Rossiya Segodnya“

Sputnik Türkiye

feedback.tr@sputniknews.com

+74956456601

MIA „Rossiya Segodnya“

Turan Salcı

https://cdn.img.anlatilaninotesi.com.tr/img/07e6/0b/1d/1063968283_0:16:787:803_100x100_80_0_0_387a309ad057f292b54c4dbdabaf3452.jpg

deepfake nedir, deepfake dolandırıcılık, nasıl deepfake videosu yaparım, deepfake tehlikeleri, deep nostalgia

deepfake nedir, deepfake dolandırıcılık, nasıl deepfake videosu yaparım, deepfake tehlikeleri, deep nostalgia

Ölüleri ‘canlandırmaktan’, şantaj videolarına: Deepfake nedir ve hangi tehlikeleri içeriyor?

13:24 16.02.2022 (güncellendi: 17:03 16.02.2022) Özel

Görüntü ve sesin değiştirilebildiği bir medya türü olan deepfake ile ölmüş kişilerin eski fotoğrafları hareketli hale getirilebiliyor ve ABD’li bir annenin yaptığı gibi kızının rakiplerini eleyebilmek için de kullanılabiliyor. Peki, deepfake ne anlama geliyor ve ne gibi tehlikeleri var. Teknoloji uzmanı Deniz Unay, Sputnik’e anlattı.

Teknolojinin geldiği noktada akıllı telefon uygulamalarıyla yüze çeşitli filtreler eklemek ve hatta daha genç ya da yaşlı görünmek mümkün. Son günlerde Fransız bir film yapımcısının, Türk doktor sandığı 20 yaşındaki hacker Nijeryalı’ya ‘aşık’ olmasıyla gündeme tekrar gelen deepfake teknolojisi ise, bir görüntü ve işitme manipülasyonu yöntemi olarak tanımlanıyor. Mevcut bir görüntü veya videoda yer alan bir kişinin, yapay sinir ağları ile birlikte bir başka kişinin görüntüsü ile değiştirildiği bir medya türü olan deepfake, makine öğrenme tekniklerini kullanarak, mevcut medyanın kaynak medya üzerinde üst üste konulmasıyla elde ediliyor.

Deepfake görüntüleri hangi amaçlarla kullanıldı?

Mevcut durumda, bu teknoloji ile ölmüş

kişilerin fotoğrafları

'canlandırılabiliyor'. Ölmüş yakınlarla özlem giderilmesini amaçlayan

İsrail merkezli soyağacı oluşturan bir çevrimiçi platform olan Myheritage’ın piyasaya sürdüğü

Deep Nostalgia, video canlandırma yoluyla eski fotoğrafları hareketli hale getiriyor, hatta fotoğraflardaki kişileri gülümsetiyor. Herhangi birinin fotoğrafını çıplak hale getiren

Deepnude uygulaması da sadece kadın fotoğraflarında ‘çalışması’ üzerine gelen eleştiriler dolayısıyla 2019 yılında

kapatıldı.

Bu teknolojiyi kullanarak üretilen içerikler için bir diğer örnek ise

eski ABD Başkanı Barack Obama’nın, zamanın başkanı Donald Trump’a küfür içerikli ifade kullandığı video. Bu videoda oyuncu ve yönetmen Jordan Peele’ın dudakları Obama’nın görüntüsünün üzerine eklenmiş durumda ve Obama’nın ağzından çıkan her kelime Peele’a ait.

ABD’li bir kadın olan Raffaela Spone da, kızının amigo takımına girebilmesi için, diğer gençlerin içki, sigara içtiğini gösteren ve hatta onları çıplak biçimde tasvir eden video ve fotoğraflar için bu teknolojiyi

kullandı.

‘Derin öğrenme’ ve ‘sahte’ kelimelerinin İngilizcesinden türetilmiş bir isme sahip olan bu teknolojiye Türkiye’de 2020 yılında Kemal Sunal’ın ‘başrolünde’ oynadığı bir reklam filmiyle ilk olarak rastlandı. Ancak, bu teknolojinin kullanıldığı alanlar maalesef, sadece eğlenceli videolar değil. Türkiye’de bir kadın üniversite öğrencisinin görüntüleri deepfake uygulaması kullanılarak müstehcen görüntülere eklendi ve kadın öğrenci şantaja uğradı.

Bu videolar nasıl oluşturulur?

Deepfake içerikleri pek çok internet sitesi ve uygulama üzerinden yapılabiliyor. Ancak, TikTok'ta viral olan, aktör Tom Cruise'un deepfake videolarının yaratıcısı Chris Ume’a göre, bu videoları yapmak çok da kolay değil. Ume, yarattığı videolar için aktörün farklı açılardan ve yüz ifadeleri ile 6 binden fazla görüntüsünü topladığını ve sadece deepfake teknolojisini kullanmadığını söyledi. Dijital grafik yazılımlarıyla görüntüyü kare kare düzeltmek için uğraşan Ume’un videoları oluşturması 2 ayından fazlasını aldı.

Derin öğrenme alanında araştırmalar yapan ve şu anda Apple’da makine öğrenimi yöneticisi olan Ian Goodfellow tarafından 2014 yılında icat edilen ‘çekişmeli üretici ağ’ (GAN) teknolojisiyle var olan deepfake’in tehlikeleri ne ve hangi önlemler alınmalı? Teknoloji uzmanı Deniz Unay, Sputnik’e anlattı.

‘Yararları olduğu kadar bu teknolojinin tehlikeli bir silaha dönüşebileceği uygulamalarda yer alıyor’

Temelde makine öğrenimi sınıfı olan GAN’ın, beraberinde tıp alanında kullanılan MR’dan tasarımcıların yeni kıyafetlerini modeller üzerinde sanal ortamda denemelerine kadar birçok yeni uygulamanın da ortaya çıkmasını sağladığını söyleyen Unay, “Yararları olduğu kadar bu teknolojinin tehlikeli bir silaha dönüşebileceği uygulamalarda yer alıyor. Bunlar arasında Deepfake ile oluşturulmuş insan modelleri ile videolar, belgeseller, filmler ve hatta röportajlar bile hazırlanabilir hale gelmiştir. Özellikle son dönemde gelişen uygulamalar normal bir insan tarafından anlaşılması neredeyse imkansız hale gelen görüntülerin ve seslerin ortaya çıkmasını sağlamıştır” dedi ve “Söz konusu teknolojinin yeniden gündeme gelmesinde ise Metaverse kavramına bağlanması mümkündür. İnsanların kendi üç boyutlu görüntülerini tasarlayacakları bu evrende GAN ile çok daha başarılı sonuçların elde edilmesi mümkündür” diye ekledi.

‘Deepfake teknolojisiyle yapılan dolandırıcılık tehlikesi artıyor’

Unay, bu teknolojinin kullanıldığı dolandırıcılık olaylarına da dikkat çekerek “Deepfake üzerinden artan dolandırıcılık faaliyetleri ise günümüzde birçok kişi için tehlike oluşturmaya da devam ediyor. Deepfake yardımıyla oluşturulan sahte görüntüler, özellikle ünlüler, siyasiler veya toplum tarafından tanınan bilinen kişilerin gerçekte var olmayan bir yerde olmasını, söylemedikleri şeyleri söylemeleri ve bunları yaparken de gerçeğinden ayırt edilmemeleri çok ciddi bir tehlikenin ortaya çıkmasına neden olmuştur. Deepfake teknolojisi kullanılarak yapılan dolandırıcılık faaliyetlerinin bazılarına bakıldığında bu uygulamaların gelecekte daha da tehlikeli boyutlara varabileceği düşüncesi iyice yerleşmiş durumda” diye konuştu ve dolandırıcılık örneklerini şu şekilde sıraladı:

Ses taklidiyle para çekmeden, seks şantajına kadar uzanıyor

“2019 yılında İngiltere merkezli bir şirketin CEO’sunun sesi taklit edilerek yapılan bir dolandırıcılık tehlikenin boyutlarını ortaya koymuştur. Sahte ses ile verilen talimatlar ile 243.000 dolar para transferi ile dolandırılan şirket büyük bir şaşkınlık yaşamıştır. 2020 yılında ise benzer bir olay Hong Kong’da yaşanmıştır. Bir banka müdürünün sesi taklit edilerek 35 milyon dolar miktarında dolandırıcılık gerçekleştirildiği haberi Deepfake tehlikesi ile ilgili büyük bir yankı uyandırdı. Hindistan’da ise eski bir bakanın seks şantajı yapılarak 50.000 Hindistan Rupisi dolandırılması olayı dünya gündeminde ilk sıralarda yer almıştı. Bu olayda ise bakan sosyal medya üzerinden sahte bir avatar ile sohbet etmeye başladıktan bir süre sonra soyunmasını istemiş ve bakanın izlediği görüntüler şantajcılar tarafından kaydedilerek dolandırıcılık gerçekleşmiştir.”

‘Toplumsal olaylarda sahte görüntülerin kısa sürede yayılması ve etkileşim alması çok daha geniş kitlelerin manipüle edilmesine neden olmaktadır’

Deepfake’in topluma olan etkisinden de bahseden Unay, seçim zamanlarında da manipüle edilmiş görüntülerin sunulabileceğinin mümkün olduğunu belirtti. Unay “Sahte bir profilin ötesine geçerek gerçek bir kişi gibi davranan bu hesaplar zaman içinde kalabalık kitleleri sokağa dökebilir ve yanlış siyasi yönlendirmeler ve bilgiler ile iç karışıkları bile tetikleyebilir. Seçim dönemlerinde ise Deepfake ile yapılan videolar ve gerçekte asla söylenmemiş şeyleri belirli siyasi kişilerin demeçleri olarak yansıtılabilir. Bu sayede Deepfake teknolojisinin seçimlere etkisi görülebilecektir. Toplumsal olaylarda sahte fotoğraf, resim, ses ve videoların kısa sürede sahte hesaplar aracılığıyla yayılması ve yüksek etkileşim alması çok daha geniş kitlelerin manipüle edilmesine neden olmaktadır. Bu gibi durumlara karşı hükümetlerin de zaman zaman aldıkları önlemler tartışma yaratmaktadır” dedi.

Deepfake teknolojisiyle üretilmiş videoların gerçekliğinin çok zor bir şekilde anlaşılabildiğini söyleyen Unay’ın aktardığına göre, buna karşı herhangi bir önleyici yazılım ya da uygulama bulunmuyor.

Deepfake dolandırıcılığına karşı hangi önlemler alınabilir?

Bu teknoloji ile gerçekleştirilen dolandırıcılık faaliyetlerin korunmanın yollarını anlatan Unay “Özellikle bankacılık işlemlerinde ve uygulamalarında birkaç farklı adımdan oluşan güvenlik sistemlerinin kullanılması son derece önemlidir. Diğer yandan sesli tanıma özelliklerine sahip işlemlerin de kapatılması dolandırıcılıktan korunmanız için oldukça önemlidir. Sosyal medya veya internet üzerinde karşınıza ilk çıkan video, fotoğraf veya sesleri ilk anda doğru kabul etmemek özellikle toplumsal olayların önlenmesinde önemlidir. Bir olay sonrasında sıcağı sıcağına sosyal medyada yayılan birçok bilgi ve görüntünün sahte olduğu çok sık rastlanan bir durumdur. Bu duruma karşı alınacak önlem ise ilgili unsurların teyit edilmesi olacaktır. İnternette güvenliğin artırılmasına yönelik dikkat edilmesi gereken temel yaklaşımların tümü Deepfake dolandırıcılığına karşı kendinize daha güvenli bir alan yaratmanızı sağlayacaktır. Ancak bu teknolojiden tamamen korunmak günümüzde neredeyse imkansızdır. Bu nedenle alınabilecek basit önlemler ile internetteki varlığınızı güvence altına almak ve deepfake tehdidine karşı bilinçlenmek son derece önemlidir” ifadelerini kullandı.